Negli ultimi anni sono stati attivati molti tavoli di lavoro per far chiarezza ed indirizzare l’attenzione generale su temi etici legati alla costruzione e all’uso consapevole di sistemi di Intelligenza Artificiale. Questi gruppi di lavoro sono stati promossi da governi e organizzazioni pubbliche ma anche su iniziative e spinta privata.

L’ultimo in ordine di tempo è il report Ethics guidelines for trustworthy AI (https://ec.europa.eu/digital-single-market/en/news/ethics-guidelines-trustworthy-ai) prodotto da parte dell’EU. Questo documento, redatto con il contributo di una cinquantina di esperti di varie discipline, contribuisce a definire una roadmap e un insieme di principi guida definire le linee guida di un framework complessivo che porti alla definizione di sistemi di Intelligenza Artificiale rispettosi non solo delle leggi e dei regolamenti ma anche di principi etici.

Tre sono i principali pilastri presi in considerazione dagli autori del report su come devono essere concepiti, realizzati ed messi in produzione i sistemi di Intelligenza Artificiale quali:

- Rispettare le leggi e i regolamenti;

- Rispettare un insieme di principi e valori etici;

- Realizzare, tecnicamente, sistemi di IA “robusti” per ridurre o azzerare i rischi verso la società e verso l’ambiente.

La figura seguente tratta dal report propone un outline dei 7 requisiti che devono essere rispettati per definire un sistema di IA “trusted”.

L’IEEE ha pubblicato un rapporto dal titolo “Global Initiative on Ethics of Autonomous and Intelligent Systems” (https://ethicsinaction.ieee.org/#read). Questo report include contributi a livello globale prodotti dai membri dell’IEEE in rappresentanza di tutti i continenti e fornisce un insieme di indicazioni per definire regole di governance dell’Intelligenza Artificiale riguardanti ad esempio il trattamento dei dati, gli aspetti legali ed economici, aspetti legati all’analisi di dati personali e sensibili e molte altre aree.

I principi di riferimento considerati in questo studio dell’IEEE:

- Il benessere (o well-being) dell’uomo deve essere sempre la chiave della misura del successo di un progetto di Intelligenza Artificiale. L’uomo e la società è al centro, in sostanza, di concerto con la possibilità di migliorare la prosperità economica e sociale in modo olistico. Quest’ultimo dovrebbe essere il driver principale piuttosto che perseguire un solo obiettivo come il miglioramento della produttività, ad esempio.

- Occorre fare crescere la conoscenza dei principi etici dell’intelligenza artificiale all’interno di ogni tipo di organizzazione. Occorre che tutte le figure professionali coinvolte siano formate su questi argomenti.

- Guidare e non essere guidati in fatto di etica. Accedere ma anche contribuire all’applicazione degli standard all’interno delle organizzazioni. Ad esempio, è ritenuto molto importante individuare e caratterizzare gli impatti strategici e tattici che i sistemi di Intelligenza Artificiale possono determinare all’interno della propria organizzazione.

Un altro lavoro ben noto in questo ambito è quello chiamato “The 23 Asilomar Principles” (https://futureoflife.org/ai-principles/). Il nome è un po’ criptico. In realtà e’ un lavoro pubblicato nel 2017 e promosso da un centinaio di scienziati, filosofi, ricercatori e leader industriali e promosso dal Future of Life Institute e redatto durante un summit tenutosi nella cittadina di Asilomar in California. Questo istituto è stato fondato nel 2014 per promuovere iniziative che possano sviluppare una visione “ottimistica” del futuro e la salvaguardia della vita rispetto a sfide e minacce globali come cambiamenti climatici, lo sviluppo di armi di distruzione di massa, l’uso improprio e non etico delle tecniche biotecnologie e, chiaramente, l’intelligenza artificiale.

I principi fondanti che questo lavoro propone per indirizzare gli sforzi di ricerca i seguenti:

- I sistemi di Intelligenza Artificiale devono essere sviluppati per il bene comune: lo scopo della ricerca in Intelligenza Artificiale deve essere quello di non creare forme di intelligenza autonoma o non super intelligenze ma creare sistemi intelligenti che possano dare un beneficio.

- Favorire una cultura basata sulla fiducia: si auspica che emerga tra i gruppi di ricerca in IA una la cooperazione aperta, fiducia reciproca, trasparenza su come i sistemi sono realizzati ed operano.

- Più cooperazione e meno competizione: i gruppi di ricerca che sviluppano sistemi di intelligenza artificiale dovrebbero evitare atteggiamenti competitivi ma dovrebbero, invece, favori la cooperazione e contribuire a definire standard condivisi.

L’AI Now Institute della New York University ha promosso e pubblicato nel 2018 un report dove propone un framework per modulare ed adeguare le policy sia di organizzazioni pubbliche sia di aziende private per la protezione dei diritti (e dei dati) dei cittadini rispetto ai potenziali rischi posti dall’Intelligenza Artificile (https://ainowinstitute.org/AI_Now_2018_Report.pdf).

Alcuni principi chiave considerati in questo lavoro richiedono ad esempio che:

- I governi debbano regolare l’uso dell’IA auspicando l’espansione dei poteri e delle competenze delle agenzie di controllo e regolazione di ciascun settore

- Il settore industriale deve, e con urgenza, definire e promuove nuovi approcci condivisi per la governance dei sistemi di IA per rendere chiari le responsabilità degli stessi.

- Le agenzie che sovrintendono i diritti e la protezione dei consumatori da messaggi ingannevoli dovrebbero applicare gli stessi principi ai prodotti e ai servizi di IA.

Nel 2018 al parlamento europeo è stato presentato da parte del Prof. Luciano Floridi il lavoro realizzato da parte di AI4People AI4People’s “Ethical Framework for a Good AI Society: Opportunities, Risks, Principles, and Recommendations” (http://www.eismd.eu/ai4people-ethical-framework/). AI4People è un forum che mette assieme vari attori interessati a valutare l’impatto sulla società delle nuove applicazioni di Intelligenza Artificiale.

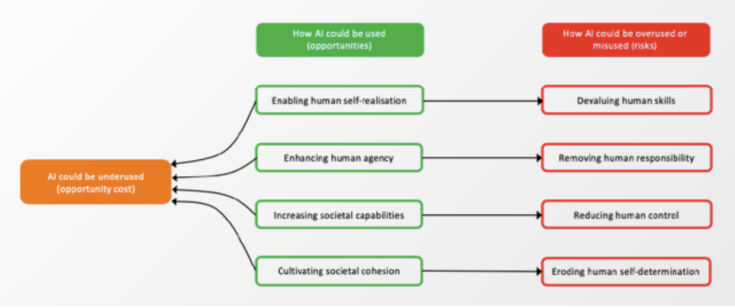

I principi definiti da questo gruppo di lavoro sono riportati nella figura seguente tratta dallo stesso report.

Anche in questo lavoro emergono indicazioni guida di base simili negli altri casi quali:

- Tenere gli umani nella cabina di regia

- Puntare e sforzarsi di perseguire il bene comune

- Preservare le specificità di ciascuno

Infine, un ultimo lavoro da citare è quello condotto nell’ambito del comitato ISO SC42 nato per definire standard sul tema AI ed avviato a gennaio 2018 (https://www.iso.org/committee/6794475.html). L’ISO SC42 ha un workingroup dedicato al tema chiamato AI Trustworthiness e vede la partecipazione ai lavori di rappresentanti di più di venti nazioni. Anche in questo caso l’obiettivo è quello di definire e formulare possibili iniziative e individuare aree dove promuove standard condivisi. Questo gruppo di lavoro è stato creato durante la seconda seduta plenaria del comitato SC42 tenutosi in California nel 2018 e nel successivo meeting plenario in Irlanda ha già prodotto vari risultati che costituiranno indicazioni di standard nei prossimi mesi.

Leave a comment